La inteligencia artificial está malinterpretando las emociones humanas

No hay pruebas convincentes de que las expresiones faciales revelen los sentimientos de una persona.

Pero las grandes empresas de tecnología quieren que usted crea lo contrario.

Aun puesto remoto en las montañas montañosas de Papúa Nueva Guinea, llegó un joven psicólogo estadounidense llamado Paul Ekman con una colección de tarjetas didácticas y una nueva teoría. Era 1967, y Ekman había oído que la gente Fore de Okapa estaba tan aislada del resto del mundo que serían sus sujetos de prueba ideales.

Como los investigadores occidentales antes que él, Ekman había venido a Papúa Nueva Guinea para extraer datos de la comunidad indígena. Estaba reuniendo pruebas para respaldar una hipótesis controvertida: que todos los seres humanos exhiben una pequeña cantidad de emociones o afectos universales que son innatos e iguales en todo el mundo. Durante más de medio siglo, esta afirmación ha sido polémica, disputada entre psicólogos, antropólogos y tecnólogos. No obstante, se convirtió en una semilla para un mercado en crecimiento que tendrá un valor estimado de $ 56 mil millones para 2024 . Esta es la historia de cómo el reconocimiento de afectos llegó a ser parte de la industria de la inteligencia artificial y los problemas que presenta.

Cuando Ekman llegó a los trópicos de Okapa, realizó experimentos para evaluar cómo Fore reconocía las emociones. Debido a que Fore tenía un contacto mínimo con los occidentales y los medios de comunicación, Ekman había teorizado que su reconocimiento y exhibición de expresiones centrales probaría que tales expresiones eran universales. Su método fue simple. Les mostraría tarjetas de memoria flash de expresiones faciales y vería si describían la emoción como él lo hizo. En palabras del propio Ekman , "Todo lo que estaba haciendo era mostrar imágenes divertidas". Pero Ekman no tenía formación en historia, lengua, cultura o política de Fore. Sus intentos de realizar sus experimentos con tarjetas de memoria flash utilizando traductores fracasaron; él y sus súbditos estaban exhaustos por el proceso, que describió como como sacar los dientes. Ekman se fuePapua Nueva Guinea, frustrado por su primer intento de investigación transcultural sobre la expresión emocional. Pero esto sería solo el comienzo.

Hoy en día, las herramientas de reconocimiento de afectos se pueden encontrar en los sistemas de seguridad nacional y en los aeropuertos, en la educación y la contratación de empresas emergentes, en software que pretende detectar enfermedades psiquiátricas y programas de vigilancia que pretenden predecir la violencia. La afirmación de que el estado interior de una persona puede evaluarse con precisión analizando el rostro de esa persona se basa en pruebas inestables . Una revisión sistemática de 2019de la literatura científica sobre inferir emociones a partir de movimientos faciales, dirigida por la psicóloga y neurocientífica Lisa Feldman Barrett, encontró que no hay evidencia confiable de que se pueda predecir con precisión el estado emocional de alguien de esta manera. “No es posible inferir con seguridad la felicidad de una sonrisa, la ira de un ceño fruncido o la tristeza de un ceño fruncido, como intenta hacer gran parte de la tecnología actual al aplicar lo que se cree erróneamente que son hechos científicos”, concluye el estudio . Entonces, ¿por qué la idea de que existe un pequeño conjunto de emociones universales, que se interpretan fácilmente a partir del rostro de una persona, se ha vuelto tan aceptada en el campo de la IA?

Comprender eso requiere rastrear la compleja historia y los incentivos detrás de cómo se desarrollaron estas ideas, mucho antes de que las herramientas de detección de emociones de IA se integraran en la infraestructura de la vida cotidiana.

La idea del reconocimiento de afectos automatizado es tan convincente como lucrativa. Las empresas de tecnología han capturado inmensos volúmenes de imágenes superficiales de expresiones humanas, incluidos miles de millones de selfies de Instagram, retratos de Pinterest, videos de TikTok y fotos de Flickr. Al igual que el reconocimiento facial, el reconocimiento de afectos se ha convertido en parte de la infraestructura central de muchas plataformas, desde las mayores empresas de tecnología hasta las pequeñas empresas emergentes.

Mientras que el reconocimiento facial intenta identificar a un individuo en particular, el reconocimiento afectivo tiene como objetivo detectar y clasificar las emociones analizando cualquier rostro. Estos sistemas ya influyen en cómo se comportan las personas y cómo operan las instituciones sociales, a pesar de la falta de evidencia científica sustancial de que funcionen. Los sistemas automatizados de detección de afectos ahora se implementan ampliamente, particularmente en la contratación. La empresa de contratación de IA HireVue, que puede incluir a Goldman Sachs, Intel y Unilever entre sus clientes, utiliza el aprendizaje automático para inferir la idoneidad de las personas para un trabajo. En 2014, la compañía lanzó su sistema de inteligencia artificial para extraer microexpresiones, tono de voz y otras variables de las entrevistas de trabajo en video, que utilizó para comparar a los solicitantes de empleo con los de mejor desempeño de una empresa. Después de considerables críticas de académicos y grupos de derechos civiles, abandonó el análisis facial en 2021, pero mantuvo el tono vocal como criterio de evaluación. En enero de 2016, Apple adquirió la empresa emergente Emotient, que afirmó haber producido un software capaz de detectar emociones a partir de imágenes de rostros. Quizás la más grande de estas nuevas empresas es Affectiva, una empresa con sede en Boston que surgió del trabajo académico realizado en el MIT.

Affectiva ha codificado una variedad de aplicaciones relacionadas con las emociones, principalmente utilizando técnicas de aprendizaje profundo. Estos enfoques incluyen la detección de conductores distraídos y "riesgosos" en las carreteras y la medición de las respuestas emocionales de los consumidores a la publicidad. La compañía ha construido lo que llama la base de datos de emociones más grande del mundo, compuesta por más de 10 millones de expresiones de personas de 87 países. Su monumental colección de videos fue etiquetada a mano por trabajadores digitales basados principalmente en El Cairo .

Fuera del sector de las empresas emergentes, los gigantes de la inteligencia artificial como Amazon , Microsoft e IBM han diseñado sistemas para la detección de emociones. Microsoft ofrece detección de emociones percibidas en su API Face, identificando "ira, desprecio, disgusto, miedo, felicidad, neutralidad, tristeza y sorpresa", mientras que la herramienta Rekognition de Amazon proclama de manera similar que puede identificar lo que caracteriza como "las siete emociones" y "Mide cómo cambian estas cosas con el tiempo, como construir una línea de tiempo de las emociones de un actor".

Los sistemas de reconocimiento de emociones comparten un conjunto similar de planos y suposiciones fundamentales: que hay un pequeño número de categorías emocionales distintas y universales, que revelamos involuntariamente estas emociones en nuestros rostros y que pueden ser detectadas por máquinas. Estos artículos de fe son tan aceptados en algunos campos que puede parecer extraño incluso notarlos, y mucho menos cuestionarlos. Pero si miramos cómo las emociones llegaron a ser taxonomizadas, ordenadas y etiquetadas cuidadosamente, vemos que las preguntas acechan en cada esquina.

Einvestigación de kman comenzó con un encuentro afortunado con Silvan Tomkins, a continuación, un psicólogo establecido en Princeton que había publicado el primer volumen de su obra magna, afectar la conciencia de Imágenes , en el trabajo de 1962. de Tomkins en el afecto tenido una enorme influencia en Ekman, quien dedicó gran parte de su carrera al estudio de sus implicaciones. Un aspecto en particular jugó un papel descomunal: la idea de que si los afectos son un conjunto innato de respuestas evolutivas, serían universales y, por lo tanto, reconocibles en todas las culturas. Este deseo de universalidad tiene una relación importante con la razón por la que esta teoría se aplica ampliamente en los sistemas de reconocimiento de emociones de IA en la actualidad. La teoría se podía aplicar en todas partes, una simplificación de la complejidad que se podía reproducir fácilmente a escala.

En la introducción a la conciencia de las imágenes afectivas, Tomkins enmarcó su teoría de los afectos universales de base biológica como una que aborda una aguda crisis de la soberanía humana. Estaba desafiando el desarrollo del conductismo y el psicoanálisis, dos escuelas de pensamiento que él creía que trataban la conciencia como un mero subproducto que estaba al servicio de otras fuerzas. Señaló que la conciencia humana había "sido desafiada y reducida una y otra vez, primero por Copérnico", que desplazó al hombre del centro del universo, "luego por Darwin", cuya teoría de la evolución hizo añicos la idea de que los humanos fueron creados a la imagen. de un Dios cristiano - “y sobre todo por Freud” - que descentra la conciencia humana y la razón como fuerzas impulsoras detrás de nuestras motivaciones. Tomkins continuó, "La paradoja del control máximo sobre la naturaleza y el control mínimo sobre la naturaleza humana es en parte un derivado del descuido del papel de la conciencia como mecanismo de control". En pocas palabras, la conciencia nos dice poco sobre por qué sentimos y actuamos de la manera en que lo hacemos. Esta es una afirmación crucial para todo tipo de aplicaciones posteriores de la teoría del afecto, que enfatizan la incapacidad de los humanos para reconocer tanto el sentimiento como la expresión de los afectos. Si nosotros, como humanos, somos incapaces de detectar realmente lo que estamos sintiendo, entonces, ¿tal vez los sistemas de IA puedan hacerlo por nosotros?

La teoría de los afectos de Tomkins fue su forma de abordar el problema de la motivación humana. Argumentó que la motivación estaba gobernada por dos sistemas: afectos e impulsos. Tomkins propuso que los impulsos tienden a estar estrechamente asociados con necesidades biológicas inmediatas, como el hambre y la sed. Son instrumentales; el dolor del hambre se puede remediar con la comida. Pero el sistema principal que gobierna la motivación y el comportamiento humanos es el de los afectos, que implica sentimientos positivos y negativos. Los afectos, que desempeñan el papel más importante en la motivación humana, amplifican las señales de impulso, pero son mucho más complejos. Por ejemplo, es difícil conocer las causas precisas que llevan a un bebé a llorar, expresando el afecto de angustia-angustia.

¿Cómo podemos saber algo sobre un sistema en el que las conexiones entre causa y efecto, estímulo y respuesta son tan tenues e inciertas? Tomkins propuso una respuesta: “Los afectos primarios. . . parecen estar relacionados de forma innata de forma individualizada con un sistema de órganos que es extraordinariamente visible ”, a saber, el rostro. Encontró precedentes de este énfasis en la expresión facial en dos obras publicadas en el siglo XIX: La expresión de las emociones en el hombre y los animales de Charles Darwin , de 1872, y un oscuro volumen del neurólogo francés Guillaume-Benjamin-Amand Duchenne de Boulogne de 1862.

Tomkins asumió que la exhibición facial de afectos era un rasgo humano universal. Los “afectos”, creía Tomkins, “son conjuntos de respuestas musculares, vasculares y glandulares ubicadas en la cara y también ampliamente distribuidas por el cuerpo, que generan retroalimentación sensorial. . . Estos conjuntos organizados de respuestas se activan en centros subcorticales donde se almacenan 'programas' específicos para cada afecto distinto ”, un uso muy temprano de una metáfora computacional para un sistema humano. Pero Tomkins reconoció que la interpretación de las manifestaciones afectivas depende de factores individuales, sociales y culturales. Admitió que había "dialectos" muy diferentes del lenguaje facial en diferentes sociedades. Incluso el antepasado de la investigación afectiva planteó la posibilidad de que la interpretación de las manifestaciones faciales dependa del contexto social y cultural.

Dado que las expresiones faciales son culturalmente variables, su uso para entrenar sistemas de aprendizaje automático mezclaría inevitablemente todo tipo de contextos, señales y expectativas diferentes. El problema para Ekman, y más tarde para el campo de la visión por computadora, fue cómo conciliar estas tensiones.

A mediados de la década de 1960, la oportunidad llamó a la puerta de Ekman en forma de una gran subvención de lo que ahora se llama la Agencia de Proyectos de Investigación Avanzada de Defensa (DARPA), un brazo de investigación del Departamento de Defensa. El considerable apoyo financiero de DARPA permitió a Ekman comenzar sus primeros estudios para demostrar la universalidad en la expresión facial. En general, estos estudios siguieron un diseño que se copiaría en los primeros laboratorios de IA. Duplicó en gran medida los métodos de Tomkins, incluso usando fotografías de Tomkins para probarsujetos de Chile, Argentina, Brasil, Estados Unidos y Japón. A los sujetos se les presentaron fotografías de expresiones faciales planteadas, seleccionadas por los diseñadores por ejemplificar o expresar un afecto particularmente “puro”, como miedo, sorpresa, ira, felicidad, tristeza y disgusto. Luego se pidió a los sujetos que eligieran entre estas categorías de afecto y etiquetaran la imagen presentada. El análisis midió el grado en que las etiquetas elegidas por los sujetos se correlacionaban con las elegidas por los diseñadores.

Desde el principio, la metodología tuvo problemas. El formato de respuesta de elección forzada de Ekman sería luego criticado por alertar a los sujetos sobre las conexiones que los diseñadores ya habían hecho entre las expresiones faciales y las emociones. Además, el hecho de que estas emociones fueran falsas suscitaría dudas sobre la validez de los resultados.

La idea de que los estados interiores pueden inferirse de forma fiable a partir de signos externos tiene una larga historia. Se deriva en parte de la historia de la fisonomía, que se basaba en el estudio de los rasgos faciales de una persona en busca de indicaciones de su carácter. Aristóteles creía que “es posible juzgar el carácter de los hombres por su apariencia física. . . porque se ha asumido que el cuerpo y el alma se ven afectados juntos ". Los griegos también usaron la fisonomía como una forma temprana de clasificación racial, aplicada al "género del hombre mismo, dividiéndolo en razas, en la medida en que difieren en apariencia y carácter (por ejemplo, egipcios, tracios y escitas)".

La fisonomía en la cultura occidental alcanzó un punto álgido durante los siglos XVIII y XIX, cuando se la consideró parte de las ciencias anatómicas. Una figura clave en esta tradición fue el pastor suizo Johann Kaspar Lavater, quien escribió Ensayos sobre fisonomía: para la promoción del conocimiento y el amor a la humanidad., publicado originalmente en alemán en 1789. Lavater adoptó los enfoques de la fisonomía y los combinó con los últimos conocimientos científicos. Creía que la estructura ósea era una conexión subyacente entre la apariencia física y el tipo de carácter. Si las expresiones faciales eran fugaces, los cráneos parecían ofrecer un material más sólido para las inferencias fisonómicas. La medición del cráneo era una técnica popular en la ciencia racial y se usaba para apoyar el nacionalismo, la supremacía blanca y la xenofobia. Este trabajo fue infamemente elaborado a lo largo del siglo XIX por frenólogos como Franz Joseph Gall y Johann Gaspar Spurzheim, así como en criminología científica a través del trabajo de Cesare Lombroso.

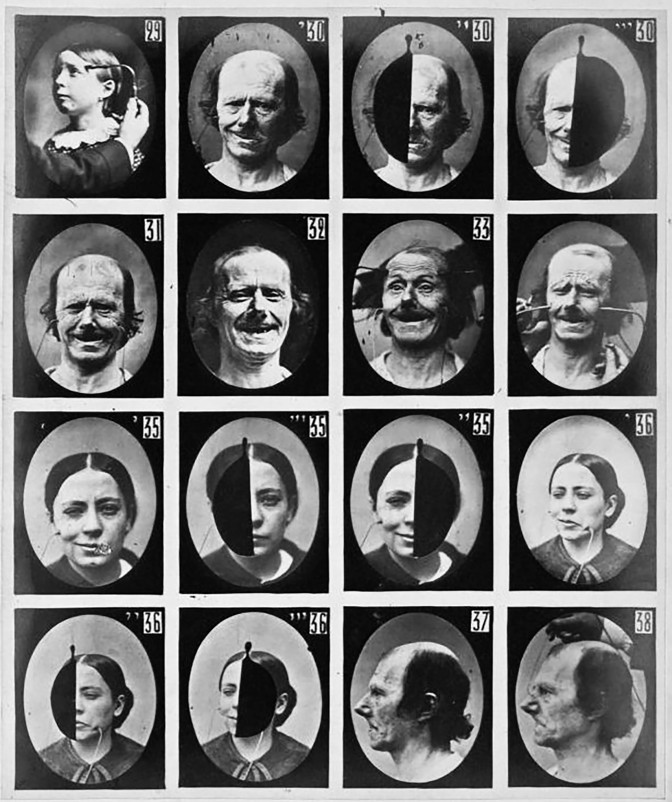

Pero fue el neurólogo francés Duchenne, descrito por Ekman como un "observador maravillosamente dotado", quien codificó el uso de la fotografía y otros medios técnicos en el estudio de los rostros humanos. En Mécanisme de la physionomie humaine , Duchenne sentó bases importantes tanto para Darwin como para Ekman, conectando ideas más antiguas de la fisonomía y la frenología con investigaciones más modernas sobre fisiología y psicología. Reemplazó vagas afirmaciones sobre el carácter con una investigación más limitada sobre la expresión y los estados mentales y emocionales interiores.

Duchenne trabajó en París en el asilo Salpêtrière, que albergaba hasta 5.000 personas con una amplia gama de enfermedades mentales y afecciones neurológicas. Algunos se convertirían en sus sujetos de angustiosos experimentos, parte de la larga tradición de experimentación médica y tecnológica con los más vulnerables, los que no pueden negarse. Duchenne, poco conocido en la comunidad científica, decidió desarrollar técnicas de descargas eléctricas para estimular los movimientos musculares aislados en el rostro de las personas. Su objetivo era desarrollar una comprensión anatómica y fisiológica más completa del rostro. Duchenne utilizó estos métodos para unir la nueva ciencia psicológica y el estudio mucho más antiguo de los signos fisonómicos o pasiones.. Se basó en los últimos avances fotográficos, como el procesamiento de colodión, que permitió tiempos de exposición mucho más cortos, lo que permitió a Duchenne congelar movimientos musculares fugaces y expresiones faciales en imágenes.

Incluso en estas primeras etapas, los rostros nunca fueron expresiones humanas naturales o de ocurrencia social, sino simulaciones producidas por la aplicación bruta de electricidad a los músculos. Independientemente, Duchenne creía que el uso de la fotografía y otros sistemas técnicos transformaría el blando negocio de la representación en algo objetivo y probatorio, más adecuado para el estudio científico. Darwin elogió las "magníficas fotografías" de Duchenne e incluyó reproducciones en su propio trabajo.

Ekman seguiría a Duchenne al colocar la fotografía en el centro de su práctica experimental. Creía que la fotografía en cámara lenta era esencial para su enfoque, porque muchas expresiones faciales operan en los límites de la percepción humana. El objetivo era encontrar las llamadas microexpresiones, pequeños movimientos de los músculos de la cara.

Uno de los ambiciosos planes de Ekman en sus primeras investigaciones fue codificar un sistema para detectar y analizar las expresiones faciales. En 1971, co-publicó una descripción de lo que llamó la Técnica de Puntuación del Afecto Facial (FAST).

Basándose en fotografías posadas, el enfoque utilizó seis tipos emocionales básicos derivados en gran medida de las intuiciones de Ekman. Pero FAST pronto tuvo problemas cuando otros científicos encontraron expresiones faciales no incluidas en su tipología. Entonces, Ekman decidió basar su próxima herramienta de medición en la musculatura facial, remontándose a los estudios originales de electroshock de Duchenne. Ekman identificó aproximadamente 40 contracciones musculares distintas en la cara y llamó a los componentes básicos de cada expresión facial una "unidad de acción". Después de algunas pruebas y validaciones, Ekman y Wallace Friesen publicaron el Sistema de codificación de acción facial (FACS) en 1978; las ediciones actualizadas continúan siendo ampliamente utilizadas.

A pesar de su éxito financiero, el uso de FACS fue muy laborioso. Ekman escribió que tomó de 75 a 100 horas capacitar a los usuarios en la metodología FACS y una hora para obtener un minuto de metraje facial. Este desafío presentó exactamente el tipo de oportunidad que el campo emergente de la visión por computadora estaba ansioso por asumir.

El uso de computadoras en el reconocimiento de afectos comenzó a tomar forma, los investigadores reconocieron la necesidad de una colección de imágenes estandarizadas para experimentar. Un informe de la National Science Foundation de 1992 coescrito por Ekman recomendó que "una base de datos multimedia de fácil acceso compartida por la diversa comunidad de investigación facial sería un recurso importante para la resolución y extensión de problemas relacionados con la comprensión facial". En un año, el Departamento de Defensa comenzó a financiar un programa para recopilar fotografías faciales. A fines de la década, los investigadores de aprendizaje automático habían comenzado a ensamblar, etiquetar y hacer públicos los conjuntos de datos que impulsan gran parte de la investigación actual sobre aprendizaje automático. Laboratorios académicos y empresas trabajaron en proyectos paralelos, creando decenas de bases de datos fotográficas. Por ejemplo, investigadores de un laboratorio en Suecia crearon Karolinska dirigió caras emocionales . Esta base de datos comprende imágenes de individuos que retratan expresiones emocionales planteadas correspondientes a las categorías de Ekman. Han dado a sus rostros formas que concuerdan con seis estados emocionales básicos: alegría, ira, disgusto, tristeza, sorpresa y miedo. Al mirar estos conjuntos de entrenamiento, es difícil no sorprenderse con una sensación de pantomima: ¡Increíble sorpresa! ¡Alegría abundante! ¡Miedo paralizante! Estos sujetos están literalmente creando emociones legibles por máquina.

A medida que el campo crecía en escala y complejidad, también lo hacían los tipos de fotografías utilizadas en el reconocimiento de afectos. Los investigadores comenzaron a utilizar el sistema FACS para etiquetar los datos generados no a partir de expresiones planteadas sino más bien a partir de expresiones faciales espontáneas, a veces recopiladas fuera de las condiciones del laboratorio. El trabajo de Ekman tuvo una profunda y amplia influencia. El New York Times describió a Ekman como "el lector de rostros más famoso del mundo", y Timelo nombró una de las 100 personas más influyentes del mundo. Eventualmente consultaría con clientes tan dispares como el Dalai Lama, el FBI, la CIA, el Servicio Secreto y el estudio de animación Pixar, que querían crear representaciones más realistas de caras de dibujos animados. Sus ideas se convirtieron en parte de la cultura popular, incluidas en best sellers como Blink de Malcolm Gladwell y un drama televisivo, Lie to Me , en el que Ekman fue consultor para el papel del personaje principal, aparentemente basado libremente en él.

Su negocio prosperó: Ekman vendió técnicas de detección de engaños a agencias como la Administración de Seguridad en el Transporte, que las utilizó para desarrollar el programa de Selección de Pasajeros por Técnicas de Observación (SPOT). SPOT se ha utilizado para monitorear las expresiones faciales de los viajeros aéreos desde los ataques del 11 de septiembre, en un intento de detectar "automáticamente" a los terroristas. El sistema utiliza un conjunto de 94 criterios, todos los cuales supuestamente son signos de estrés, miedo o engaño. Pero buscar estas respuestas significa que algunos grupos están inmediatamente en desventaja. Cualquiera que esté estresado, incómodo al ser interrogado o haya tenido experiencias negativas con la policía y los guardias fronterizos puede obtener una puntuación más alta. Esto crea sus propias formas de discriminación racial. El programa SPOT ha sido criticado por la Oficina de Responsabilidad del Gobierno y grupos de libertades civiles por su prejuicio racial y falta de metodología científica. A pesar de su precio de 900 millones de dólares, hayno hay evidencia de que haya producido éxitos claros.

Amedida que se extendía la fama de ekman, también lo hacía el escepticismo de su trabajo, con críticas que emergían de varios campos. Una de las primeras críticas fue la antropóloga cultural Margaret Mead, quien debatió sobre Ekman sobre la cuestión de la universalidad de las emociones a fines de la década de 1960. Mead no estaba convencido de la creencia de Ekman en los determinantes biológicos universales de la conducta que existen por separado de los factores culturales altamente condicionados.

Científicos de diferentes campos se unieron al coro a lo largo de las décadas. En años más recientes, los psicólogos James Russell y José-Miguel Fernández-Dols han demostrado que los aspectos más básicos de la ciencia siguen siendo inciertos. Quizás la principal crítica de la teoría de Ekman es la historiadora de la ciencia Ruth Leys, quien ve una circularidad fundamental en el método de Ekman. Se asumió que las fotografías planteadas o simuladas que usó expresaban un conjunto de estados afectivos básicos que, escribió Leys , "ya estaban libres de influencia cultural". Estas fotografías se utilizaron luego para obtener etiquetas de diferentes poblaciones para demostrar la universalidad de las expresiones faciales. La psicóloga y neurocientífica Lisa Feldman Barrett lo expresasin rodeos: “Las empresas pueden decir lo que quieran, pero los datos son claros. Pueden detectar un ceño fruncido, pero eso no es lo mismo que detectar enojo ".

Más preocupante aún es que en el campo del estudio de las emociones, los investigadores no han llegado a un consenso sobre qué es realmente una emoción. Qué son las emociones, cómo se formulan y expresan dentro de nosotros, cuáles podrían ser sus funciones fisiológicas o neurobiológicas, su relación con los estímulos, todo esto permanece obstinadamente sin resolver . ¿Por qué, con tantas críticas, ha perdurado el enfoque de “leer las emociones” del rostro de una persona? Desde la década de 1960, impulsados por importantes fondos del Departamento de Defensa, se han desarrollado múltiples sistemas que son cada vez más precisos para medir los movimientos faciales. La teoría de Ekman parecía ideal para la visión por computadora porque podía automatizarse a escala. La teoría se ajusta a lo que podrían hacer las herramientas.

Se han realizado poderosas inversiones institucionales y corporativas basadas en la validez percibida de las teorías y metodologías de Ekman. Reconocer que las emociones no se clasifican fácilmente, o que no son detectables de manera confiable a partir de las expresiones faciales, podría socavar una industria en expansión. Muchos artículos sobre aprendizaje automático citan a Ekman como si estos problemas estuvieran resueltos, antes de pasar directamente a los desafíos de ingeniería. Las cuestiones más complejas de contexto, condicionamiento, relacionalidad y cultura a menudo se ignoran. El propio Ekman ha dicho que le preocupa cómo se comercializan sus ideas , pero cuando le escribe a las empresas de tecnología pidiendo pruebas de que sus programas de reconocimiento de emociones funcionan, no ha recibido respuesta.

En lugar de intentar construir más sistemas que agrupen expresiones en categorías legibles por máquina, deberíamos cuestionar los orígenes de esas categorías en sí mismas, así como sus consecuencias sociales y políticas. Por ejemplo, se sabe que estos sistemas señalan los efectos del habla de las mujeres, en particular de las mujeres negras, de manera diferente a los de los hombres. Un estudio realizado en la Universidad de Maryland ha demostrado que algún software de reconocimiento facial interpreta que los rostros negros tienen más emociones negativas que los rostros blancos, registrándolos específicamente como más enojados y más despectivos, incluso cuando se controla su grado de sonrisa.

Este es el peligro de automatizar el reconocimiento de emociones. Estas herramientas pueden llevarnos al pasado frenológico, cuando se usaban afirmaciones falsas para respaldar los sistemas de poder existentes. Las décadas de controversia científica en torno a inferir estados emocionales consistentemente a partir del rostro de una persona subraya un punto central: la “detección” única para todos no es el enfoque correcto. Las emociones son complicadas y se desarrollan y cambian en relación con nuestras culturas e historias, todos los contextos múltiples que viven fuera del marco de la IA.

Pero ya, los solicitantes de empleo son juzgados injustamente porque sus expresiones faciales o tonos vocales no coinciden con los de otros empleados. Los estudiantes son señalados en la escuela porque sus rostros parecen enojados y los clientes son interrogados porque sus señales faciales indican que pueden ser ladrones. Estas son las personas que asumirán los costos de los sistemas que no solo son técnicamente imperfectos, sino que se basan en metodologías cuestionables. Una taxonomía limitada de emociones, derivada de los experimentos iniciales de Ekman, se está codificando en sistemas de aprendizaje automático como un indicador de la infinita complejidad de la experiencia emocional en el mundo.

Este artículo está adaptado del libro reciente de Kate Crawford, Atlas of AI: Power, Politics, and the Planetary Costs of Artificial Intelligence .

Comentarios

Publicar un comentario